Nvidia GTC Spring 2022 Hopper, Grace und Digital Twins: KI als Komplettpaket

Auf der GTC Spring 2022 stellt Nvida mit Hopper seine nächste GPU-Architektur vor. Zunächst wird sie für KI-Systeme eingesetzt, bei denen sich Nvidia als Rundum-Anbieter etabliert: Mit GPU, ARM-CPU, Netzwerktechnik sowie passender Software und Services.

Anbieter zum Thema

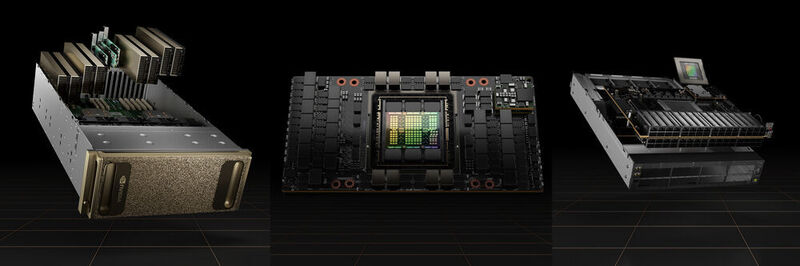

(Bild: Nvidia)

Auf Ampere folgt Hopper: Nvidia hat die nächste GPU-Architektur nach Grace Hopper benannt, die 1952 den ersten Compiler entwickelt und damit die Informatik entscheidend vorangetrieben hat. Als ersten Chip auf Basis der Hopper-Architektur präsentiert Nvidia die H100 Tensor Core GPU, die primär für KI-Workloads wie KI Training und Inference, Datenanalysen und High Performance Computing bestimmt ist. Der Chip besteht aus etwa 80 Milliarden Transistoren, fast doppelt so viel wie beim A100, und wird bei TSMC im 4N-Verfahren produziert. Laut Hersteller ist er der fortschrittlichste Chip, der derzeit gebaut wird. „Rechenzentren werden zu KI-Fabriken. Sie verarbeiten und verfeinern Berge von Daten, um Intelligenz zu produzieren”, sagt dazu Jensen Huang, CEO von Nvidia. „Nvidias H100 ist der Motor für die weltweite KI-Infrastruktur, mit der Unternehmen ihr KI-getriebenes Geschäft antreiben.” Neben der Hardware stellt Nvidia auch angepasste SDKs und Tools für verschiedenste KI-Workloads bereit. Mit der AI Enterprise 2.0 Software Suite können Unternehmen ihre KI-Anwendungen als Container unter Red Hat OpenShift und mittels VM unter vSphere auf virtuellen Maschinen nutzen.

H100: Mehr Power für Deep Learning

Der H100 ist die inzwischen neunte Generation von Nvidias Datacenter-GPUs. Im Vergleich zum Vorgänger A100 verspricht der Hersteller eine erhebliche Steigerung der Performance. Im Vollausbau besteht der Chip aus acht GPU Processing Clusters mit insgesamt 144 Streaming Prozessoren und 18.432 FP32-Cuda-Cores. Dazu kommen noch insgesamt 576 Tensor-Cores der vierten Generation und 60 MB L2-Cache. Für eine schnellere Verbindung zwischen mehreren GPUs setzt Nvidia nun eine neue Generation von NVLink mit einer Bandbreite von 900 MB/s ein, für die Verbindung zur CPU dient PCI-Express 5.0.

Beim Deep Learning, etwa für Natural Language Processing, kommt inzwischen zunehmend ein Transformer-basiertes Modell zum Einsatz, beispielsweise dem gemeinsam mit Microsoft entwickelten Megatron-Turing NLG 530B mit 530 Milliarden Parametern. Andere Einsatzbereiche für Transformer sind die Medizin mit der Proteinsequenzierung oder das maschinelle Sehen. Eine neue Transformer Engine soll dafür sorgen, dass H100 das Training dieser massiv größeren Modelle mit 6facher Performance bewältigt, ohne dabei an Genauigkeit zu verlieren. Für die dynamische Programmierung (DXP), die in der Medizin, der Routenoptimierung oder der Simulation von Quantencomputern verwendet wird, bietet die GPU einen Satz eigener DXP-Befehle. Mit ihnen lassen sich entsprechende Aufgaben um den Faktor Sieben schneller erledigen als mit einer A100-GPU.

Eine H100-GPU kann per Multi-Instance GPU der zweiten Generation in bis zu sieben voneinander isolierte Partitionen aufgeteilt werden. Mit Confidential Computing sorgt für die Sicherheit von Daten und Applikationen durch verschlüsselte Transfers zwischen dem Nvidia-Treiber in einer geschützen VM auf der CPU und der H100-GPU.

Von der PCIe-Karte bis zum Supercomputer

In den tatsächlich angebotenen H100-GPUs sind nicht alle Streaming Prozessoren aktiv. So nutzt der H100 auf den SXM5-Modulen, die auf dem HGX-H100-Server-Boards und im DGX-H100-Server zum Einsatz kommen, nur 132 Stream-Prozessoren mit 16.896 Cuda-Cores und auf den kommenden PCIe-Gen5-Karten nur 114 Stream-Prozessoren mit zusammen 14.592 Cuda-Cores.

Auf den für 700 Watt TDP ausgelegten SMX5-Boards sitzen neben der GPU noch 80 GB HBM3 in fünf Stacks, die über insgesamt zehn 512-Bit-Speichercontroller angebunden sind. Die Speicherbandbreite gibt Nvidia mit mehr als 3 TB/s an. Die PCI-Express-Karten sind mit 80 GB langsameren HBM2e als Speicher bestückt. Sie geben sich mit 350 Watt TDP zufrieden. Neben einer herkömmlichen H100-PCIe-Karte wird der Hersteller noch den H100 CNX Converged Accelerator auf den Markt bringen. Hier sitzt auf der Karte zusätzlich zur GPU noch ein ConnectX-7 SmartNIC, verbunden durch einen integrierten PCIe-Gen5-Switch. Die Karte kann so laut Nvidia in Servern ohne PCI-Express-5.0 eingesetzt werden, ohne dass ein Flaschenhals bei der Datenübertragung zwischen GPU und Netzwerk entsteht.

Die HGX-H100-Server-Boards kommen in Versionen mit vier oder acht H100-GPUs, die mittels NVLink und NVSwitch verbunden sind. Sie dienen OEM-Partnern als Basis für eigene H100-Systeme. Als erstes H100-Produkt kommt der eigene DGX-H100-Server auf den Markt. Er ist mit acht H100-GPUs mit zusammen 640 GB HBM3 und zwei x86-CPUs bestückt, zu denen Nvidia keine Details nennt. Der Arbeitsspeicher ist zwei TB groß, die NVMe-SSDs bieten insgesamt 30 TB Speicherplatz. Die KI-Gesamtleistung bei der neuen FP8-Genauigkeit soll 32 Petaflops liegen. Für die Netzwerkanbindung nutzt der Hersteller acht der eigenen ConnectX-7-Adapter und zwei Bluefield-DPUsmit 400 Gbit/s auf InfiniBand oder Ethernet.

Für höchste Anforderungen an die Rechenleistung können über einen externen NVLink-Switch bis zu 32 DGX-H100-Nodes zu einem DGX-SuperPod-Supercomputer der nächsten Generation verbunden werden.

Momentan laufen die DGX-H100-Systeme noch mit x86-Prozessoren. In Zukunft werden aber auch die CPUs von Nvidia selbst kommen. Für 2023 ist der Start des Grace-CPU-Superchips mit 144 ARM-v9-Cores und LPDDR5x mit ECC als Speicher geplant. Der Chip besteht aus zwei der im vergangenen Jahr angekündigten Grace-CPUs, die mittels NVLink-C2C verbunden sind. Mit dem Grace-Hopper-Superchip soll ebenfalls in der ersten Hälfte 2023 eine Kombination aus Grace-CPU und GPU als SoC für Large-Scale-KI-Anwendungen erscheinen.

Nvidia OVX und Omniverse

Der HGX H100 ist nicht der einzige Datacenter-Server, den Nvidia auf dem GTC präsentiert hat. Eine weitere Premiere ist der Nvidia OVX als Serversystem, mit auf dem per Omniverse erstellte komplexe Digitale Zwillinge für Industrie geschaffen und betrieben werden. Mit Hilfe der OVX-Systeme und der aus ihnen bestehenden OVX-Superpods sollen photorealistische und physikalisch korrekte Digital Twins von einzelnen Fertigungseinrichtungen, kompletten Fabriken, Verkehrswegen, Städten und sogar der kompletten Erde entstehen, die wiederum mit Daten aus der realen Welt angereichert werden. Ein Beispiel, das Nvidia anführt, ist die „Digitale Schiene Deutschland”. DB Netze baut mit Universe einen digitalen Zwilling des deutschen Schienennetzes, mit dem Systeme für die automatisierte Steuerung von Zügen trainiert und mit KI-Hilfe mögliche Probleme per vorausschauender Analyse vermieden werden sollen. Ein weiteres Feld sind die Simulation von Luftströmungen für das Design von Windparks und für Klimamodelle der gesamten Erde.

Die OVX-Server bestehen aus acht A40-GPUs, zwei Intel Xeon-Platinum-8362-CPUs und drei ConnectX-6-Netzwerkkarten. Nvidia baut die Systeme nicht selbst, sondern überlässt das zertifizierten Partnern. Dan Anfang machen Inspur, Lenovo und Supermicro, die in den kommenden Monaten erste Systeme auf den Markt bringen werden.

Die passende Netzwerk-Infrastruktur für OVX und KI-Systeme auf H100-Basis soll die 400-Gbps-Ethernet-Plattform Spectrum-4 bilden. Sie besteht aus ConnectX-7-Karten, Bluefield-3-DPUs und der neuen SN5000-Switch-Familie mit Spectrum-4-ASIC und 400G- sowie 800G-Ports.

Mit Omniverse Cloud kündigt Nvidia eine Suite von Cloud-Services an, mit der Designer, Künstler und Entwickler einfach gemeinsam an Projekten arbeiten können. Dabei können Nutzer ohne starke Rechner mit RTX-Grafik sogar die Geforce-Now-Plattform in der Cloud nutzen, um komplexe Modelle zu betrachten. Derzeit ist die Omniverse Cloud noch in der Entwicklung und nur auf Anfrage als Early Access zugänglich.

Zusätzliche Ampere-GPUs

Da die Hopper-Architektur derzeit nur High-End-GPUs für KI und HPC umfasst, schickt Nvidia für Aufgaben wie 3D-Grafik oder weniger anspruchsvolle KI- und Analytics-Workloads noch einmal eine Reihe von GPUs auf Ampere-Basis an den Start, die weitgehend den zuletzt vorgestellten Geforce-RTX-Modellen entsprechen.

Für Desktop-Workstations ist die RTX A5500 die einzige GTC-Neuheit. Die Karte entspricht mit 10.240 Cuda-, 80 RT- und 320 Gen3-Tensor-Cores sowie 24 GB Grafikspeicher weitgehend der Geforce RTX 3080 Ti. Allerdings ist sie nicht mit GDDR6X-, sondern mit GDDR6-Chips bestückt, diese dafür mit ECC. Zudem unterstützt sie NVLink.

Die RTX A5500 für mobile Workstations fällt analog zu ihrem Gaming-Schwestermodell mit 7.424 Cuda-Cores sowie 58 RT- und 232 Tensor-Cores ein gutes Stück kleiner aus. Der Grafikspeicher ist hier 16 GB groß. Darunter rangieren als weitere Neuheiten und teilweise Ablösung extistierender GPUs mit Modelle RTX A4500, RTX A3000 mit 12 GB ECC-GDDR6, RTX A2000 mit 8 GB GDDR6, RTX A1000 und RTX A500. Die beiden letzteren GPUs sind mit 2.048 Cuda-Cores und 4 GB Grafikspeicher fast identisch. Die A500 ist allerdings mit maximal 60 statt 95 Watt TGP etwas sparsamer und geringfügig langsamer. Die Desktop-Variante der RTX A5500 ist ab sofort verfügbar, Notebooks mit den neuen Mobile-GPUs sollen noch im Frühjahr auf den Markt kommen. Nvidia nennt Acer, Asus, Dell, HP, Lenovo und MSI als OEM-Partner.

:quality(80)/images.vogel.de/vogelonline/bdb/1941100/1941164/original.jpg)

(ID:48116734)

Hopper, Grace und Digital Twins: KI als Komplettpaket - IT-BUSINESS

Read More

No comments:

Post a Comment